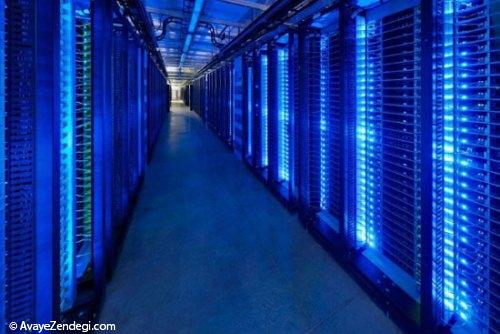

اگر برای مدت تنها ۳۰ ثانیه فیسبوک خود را روی تلفن هوشمندتان باز کنید، همین فعالیت کوتاه و ساده شما به احتمالا زیاد بیش از ۱۰۰۰ سرور را درگیر می کند که بخش اعظمی از آنها در دیتا سنترهای خود این شبکه اجتماعی قرار دارند.

از سال ۲۰۱۱ میلادی تاکنون، این سایت پایگاه های داده ای متعددی را در اورگان، آیوا، کارولینا شمالی و همچنین سوئد تاسیس کرده و در ساخت آنها نیز مبتکرانه ترین و همچنین سازگارترین اصول زیست محیطی را در نظر گرفته است که اطلاعات مربوط به همگی شان از طریق پروژه Open Compute این شرکت در دسترس عموم قرار دارند.

گفتنی است که در ماه جولای این کمپانی کار ساخت و ساز پایگاه داده ای پنجمش را در Fort Worth تگزاس آغاز کرد. در ادامه قصد داریم گشت و گذاری کوتاه داشته باشیم به درون این مراکز.

دیتاسنترهای گوگل از بیرون شبیه به کارخانجاتی عظیم به نظر می آیند. در این تصویر می توانید نمایی هوایی از تاسیسات فیسبوک واقع در کارولینای شمالی را ببینید که در زمینی به مساحت 300 هزار فوت مربع تاسیس شده است.

اما تمامی این فضا را سرورهای پیشرفته اشغال نکرده اند و در بخشی از آن نیز میزهای کارکنان قرار دارد.

این شرکت به خاطر پیاده سازی طرح های اختصاصی خود موفق شده که از سال ۲۰۱۱ میلادی تاکنون در حدود ۲ میلیارد دلار را در هزینه هایش صرفه جویی کند.

وقتی یکی از سرورهای قدیمی این شرکت را با انواع جدیدترش مقایسه نمایید به راحتی می توانید از روی اختلافات ظاهری، آنها را از یکدیگر تشخیص دهید.

فیسبوک سرورها و منابع تغذیه مورد نیازش را مطابق با خواست خود بهینه سازی کرده؛ برای نمونه منابع تغدیه مورد استفاده در این پایگاه ها بدون قطعی یا مجهز به UPS هستند که در صورت قطع شدن جریان اصلی برق، انرژی مورد نیاز دستگاه ها را تامین می کنند. این تصویر بخش داخلی دیتا سنتر این شرکت واقع در Lulwa سوئد را نشان می دهد.

در این تصویر نمای نزدیک تر یکی از سرورهای باز این شرکت را مشاهده می کنید. این قفسه در داخل زیرساخت مرکز یکپارچه سازی شده. فیسبوک فلسفه ای به نام «شبکه متصل به درگاه ها» را در پایگاه های داده ای خود پیاده سازی می کند که در اصل رابطه میان هر قطعه با شبکه برق تعریف شده است.

هدف این سایت اجتماعی آن است که دیتاسنترهای خود را تا حد ممکن مقرون به صرفه و با بهره وری مناسب طراحی کند و این یعنی شرکت مورد بحث توجه زیادی به جزئیات داشته و برای مثال از اشتباه رایج قرار دادن قاب های پلاستیکی در مقابل سرورهای خود جلوگیری می کند چراکه با این کار هوای بیشتری به داخل محفظه سرورها جریان پیدا می کند.

اما این بهره وری و مقرون به صرفگی که از آن یاد کردیم به معنای کوچک بودن مقیاس تاسیسات این شرکت نیست. نخستین پایگاه داده ای کمپانی مورد بحث در Prineville اورگان ۹۵۰ مایل کابل و سیم را در خود جای داده است (که حدودا برابر با مسافت میان بوستون و ایندیانا پلیس است).

در این تصویر می توانید نمای بیرونی دیتا سنتر فیسبوک در Prineville اورگان را مشاهده نمایید. این تاسیسات در مقایسه با ساختمان قبلی ۳۸ درصد انرژی کمتری مصرف می کند و هزینه ساختش هم ۲۴ درصد پایین تر بوده است.

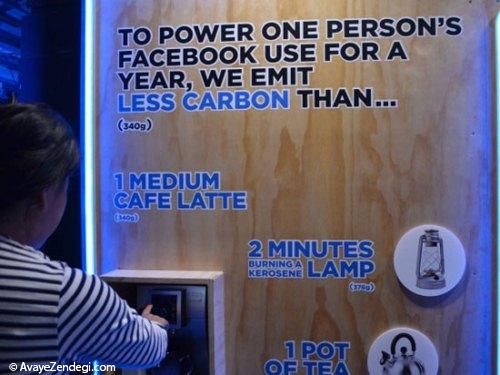

در این تصویر نوشته شده کربن تولیدی توسط فیسبوک برای آنکه امکان استفاده یک ساله از این شبکه اجتماعی را برای یک کاربر فراهم نماید در قیاس با میزان تولیدی این ماده در زمان ساخت یک فنجان کافه لاته یا دو دقیقه روشن بودن فانوس کمتر است.

به خاطر روش خاص اتصال سرورها در این پایگاه داده ای، تکنیسین ها به راحتی می توانند قطعات معیوب را پیدا کرده، از مدار خارج و یا تعمیرشان کنند.

تکنیسین های فیسبوک همچنین قادرند محدوده ای از پایگاه داده ای که مسئولیتیش را بر عهده دارند با استفاده از سیستم های تشخیص پرتابل خود تحت نظر بگیرند.

دمای این سرورها باید تا حد ممکن پایین نگه داشته شود و از گرم شدن بیش از اندازه آنها جلوگیری به عمل آید. به همین خاطر این شرکت در تاسیسات خود واقع در سوئد با استفاده از نوعی سیستم مکنده، هوای خنک را به داخل این مرکز می فرستد.

هوای خنک همچنین از طریق تعدادی فیلتر هوا و «اتاقک مه» وارد مرکز می شود؛ در این اتاقک ها با استفاده از تعدادی افشانه دما و رطوبت مرکز تعدیل می گردد.

دمایی که به این سرورها برخورد داده می شود در پاره ای از موارد زیاد هم خنک نیست. در این تصویر فضایی تحت عنوان «اتاق ترکیب» را می بینید که در آن هوای سرد بیرون با حرارت ایجاد شده توسط سرورها ترکیب می گردد تا دما تعدیل شود.

فیسبوک به کل محوطه ای که همه این اتفاقات در آن روی می دهد «پنت هاوس خنک کننده» می گوید. مدیریت این فرایند خنک سازی در نیمه بالایی پایگاه های داده ای صورت می پذیرد علت هم این است که هوای سرد معمولا پایین می آید و هوای گرم به سمت بخش های بالایی حرکت می کند.

دفعه دیگری که سری به فیسبوک خود زدید، به یاد بیاورید که همه تعاملات شما از این پایگاه های داده ای عبور خواهند کرد؛ یعنی جایی که سرورهای این شرکت روزانه بیش از ۱۰ تریلیون درخواست را مدیریت می کنند.